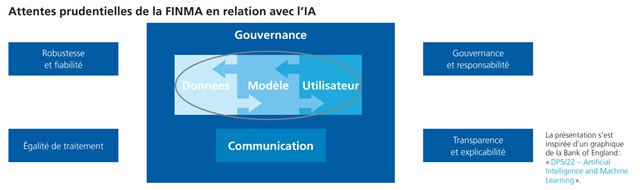

Intelligence artificielle : la FINMA formule ses attentes prudentielles

Afin de limiter les risques liés à l’utilisation de l’IA, la FINMA a concrétisé les attentes en matière de surveillance concernant l’utilisation de l’IA dans les processus de gestion des assujettis. Ces attentes, qui se concentrent sur quatre domaines (voir le graphique ci-avant), ont été concertées et affinées avec différentes parties prenantes et décrites en détail dans le monitorage des risques 2023.

Dans le domaine dynamique de l’IA, la FINMA mise fortement sur l’échange étroit avec les spécialistes en Suisse et à l’étranger ainsi qu’avec les établissements financiers qui utilisent l’AI. Il ressort des entretiens que la plupart des établissements observent très attentivement les évolutions dans ce domaine. Cependant, bon nombre d’entre eux l’expérimentent aussi dans des domaines d’utilisation présentant des risques plutôt limités. L’objectif consiste rarement en une automatisation complète et l’être humain est encore considéré comme primordial dans le processus. Le secteur salue la neutralité technologique et l’approche orientée sur les risques de la FINMA. Étant donné que l’IA est en principe une évolution technique, la plupart des établissements ne considèrent pas les risques comme fondamentalement nouveaux et en tiennent déjà compte dans le cadre de processus de gestion des risques existants.

En plus de la communication de ses attentes en matière de surveillance, la FINMA vérifie si la gestion des risques et la gouvernance de l’IA sont appropriées chez les assujettis. Afin de recenser, de limiter et de surveiller les risques spécifiques à l’IA, elle effectue depuis le quatrième trimestre 2023 des contrôles sur place et des entretiens de surveillance auprès des établissements financiers qui utilisent l’IA de manière plus intensive ou dans des domaines relevant de la surveillance. En outre, dans le cadre de la surveillance continue, elle a examiné de plus près les premières applications dans la gestion des actifs, le monitorage des transactions et la gestion des liquidités.

(Extraits du rapport annuel 2023)